Brett Simpson, socio y cofundador de Arete Research, se sentó con el director de tecnología de AMD, Mark Papermaster, durante la «Conferencia de seminarios web para inversores» del primero. La semana pasada apareció en línea una transcripción de la sesión de preguntas y respuestas de Arete + AMD: la charla informal documentada se concentró principalmente en temas del «mercado de computación de IA». Se le preguntó a Papermaster sobre el enfoque competitivo de su empresa al enfrentarse a la popular gama de GPU A100 y H100 AI de NVIDIA, así como al chip GH200 recientemente lanzado. El CTO no reveló ninguna estrategia de precios específica, sino que se pintó un «panorama general»: «Creo que lo importante cuando se da un paso atrás es mirar el costo total de propiedad, no solo una GPU, un acelerador, sino el costo total de propiedad. Pero ahora, cuando también se observa la macroeconomía, si no hay competencia en el mercado, se va a ver no solo un crecimiento del precio de estos dispositivos debido al contenido adicional que tienen, sino que, sin un control y equilibrio, se van a ver márgenes muy, muy altos, más que eso podría sostenerse sin un entorno competitivo».

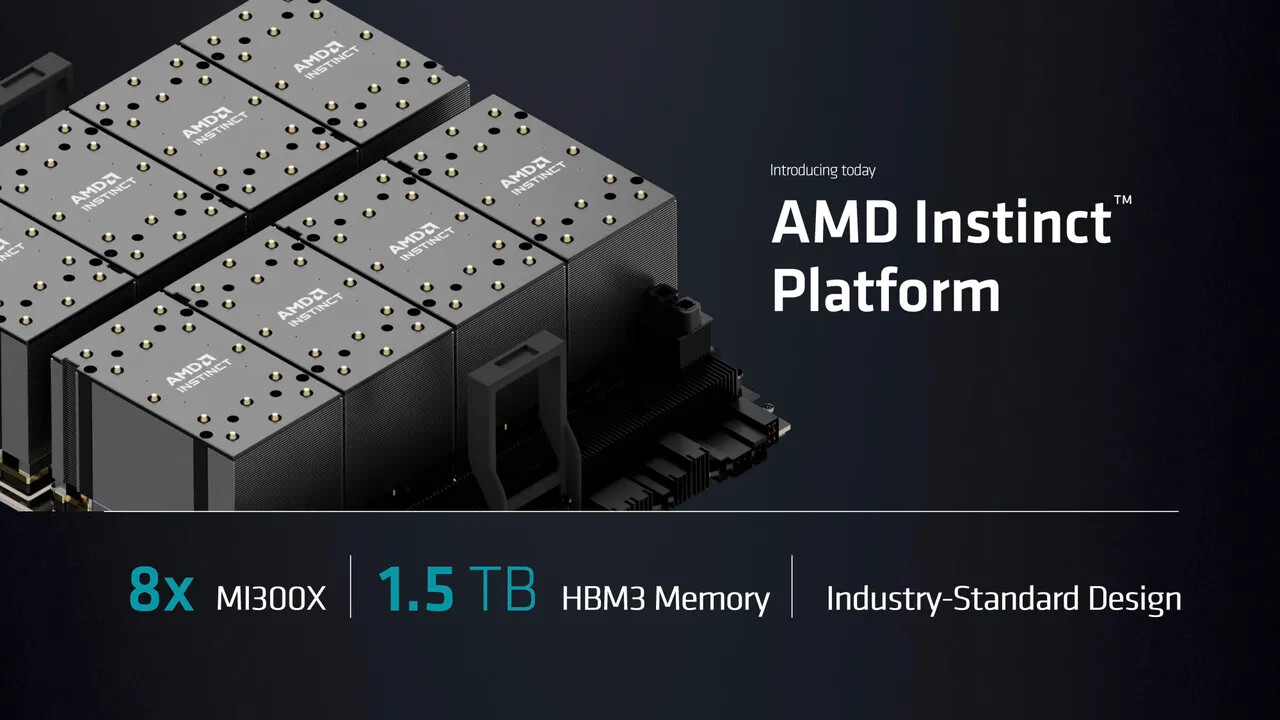

Papermaster continuó: «Y lo que creo que es muy clave con, ya que AMD ha traído un mercado competitivo para estos dispositivos de entrenamiento e inferencia de IA más poderosos, es que verá ese control y equilibrio. Y tenemos un enfoque muy innovador. Hemos sido líderes en el diseño de chiplets. Y por lo tanto, tenemos la tecnología adecuada para el propósito correcto de la construcción de IA que hacemos. Tenemos, por supuesto, un acelerador de GPU. Pero hay muchos otros circuitos asociados con la capacidad de escalar y construir estos grandes clústeres, y somos muy, muy eficientes en nuestro diseño». Team Red comenzó a enviar su acelerador insignia, Instinct MI300X, a clientes importantes a principios de 2024: Simpson, de Arete Research, preguntó sobre la posibilidad de modelos de seguimiento. En respuesta, el CTO de AMD hizo referencia a algunos antecedentes recientes: «Bueno, creo que lo primero que destacaré es lo que hicimos para llegar a este punto, donde somos una fuerza competitiva. Hemos estado invirtiendo durante años en la construcción de nuestra hoja de ruta de GPU para competir tanto en HPC como en IA. Teníamos un tren portuario muy, muy fuerte en el que hemos estado, pero tuvimos que desarrollar nuestro músculo en la habilitación del software».

Papermaster continuó con: «Y así, comenzamos hace años, un desarrollo de la pila de software ROCm. Compite de frente con CUDA. Somos capaces de ir de frente. Somos una empresa de GPU al igual que NVIDIA. Hemos competido con NVIDIA durante un año. Así que no es sorprendente que muchas de las semánticas de programación que usamos sean similares porque, francamente, hemos estado atravesando el mismo viaje durante décadas. Y eso nos llevó hasta el 6 de diciembre, cuando anunciamos el MI300. Trajimos esa competencia… Ahora estamos enviando, ahora estamos aumentando. Y eso es exactamente lo que queríamos… Y nos permitió crear un entorno aún diferente de cómo estamos trabajando con nuestros clientes más grandes. Trabajamos en estrecha colaboración con ellos y obtuvimos su opinión sobre el MI300». El lanzamiento de AMD de sus últimos productos MI300 ha generado mucho revuelo dentro de las industrias de IA, tanto que Team Green ha ajustado sus planes, según Papermaster: «Lo que se vio es que, de hecho, NVIDIA reaccionó a nuestro anuncio. De hecho, han acelerado su hoja de ruta. No nos quedamos quietos. Hicimos ajustes para acelerar nuestra hoja de ruta con ambas configuraciones de memoria en torno a la familia MI300, derivados de MI300, la próxima generación». La línea actual de aceleradores Instinct se basa en piezas HMB3, mientras que NVIDIA y sus socios de producción ya se han trasladado a HMB3E.

El CTO de Team Red no parecía demasiado preocupado por ese desarrollo: «Hemos tenido mucha experiencia en llevar memoria al clúster de cómputo de la GPU. Abrimos el camino. Y lo que ahora es CoWoS en TSMC, que es la conectividad de sustrato de silicio más utilizada para tener la conexión más eficiente de memoria de gran ancho de banda para computar. Y trabajamos muy de cerca con los tres proveedores de memoria. Por eso empezamos con el MI300 y decidimos invertir más en el complejo de HBM. Así que tenemos un mayor ancho de banda. Y eso es fundamental junto con el CDNA, que es el nombre de nuestra IP, esa es nuestra IP de cálculo de GPU para IA, junto con eso, fue el know-how de HBM lo que nos permitió establecer nuestra posición de liderazgo en la inferencia de IA».

Aparentemente, AMD está preparada para actualizar Instinct con un estándar de memoria de alto ancho de banda extendido: «Diseñamos la arquitectura para el futuro. Así que tenemos pilas de 8 pilas altas. Diseñamos la arquitectura para pilas de 12 alturas. Estamos enviando con MI300 HBM3. Hemos diseñado la arquitectura para HBM3E. Así entendemos la memoria. Tenemos la relación y tenemos el conocimiento arquitectónico para estar al tanto de las capacidades necesarias. Y debido a esa profunda historia que tenemos no solo con los proveedores de memoria, sino también con TSMC y el resto de los proveedores de sustratos y la comunidad OSAT, también nos hemos centrado en la entrega y la cadena de suministro».