AMD se ha puesto a la altura de NVIDIA e Intel en la carrera por hacer funcionar un chatbot de IA local en sus respectivos equipos. El miércoles, el centro de la comunidad de AMD dio la bienvenida a una nueva entrada de blog: el personal de IA publicó una práctica guía paso a paso sobre cómo ejecutar un modelo de lenguaje extenso (LLM) en un PC AMD Ryzen AI o en una tarjeta gráfica Radeon. Recomiendan a los interesados que descarguen la versión correcta de LM Studio. Su variante de Windows para CPU -diseñada para los chips de gama alta Phoenix y Hawk Point- compatible con los PC Ryzen AI puede desplegar instancias de un chatbot AI basado en GPT y alimentado por LLM. La vista previa técnica de LM Studio ROCm funciona de forma similar, pero depende de la posesión de una tarjeta gráfica Radeon RX 7000. Los objetivos de GPU compatibles son: gfx1100, gfx1101 y gfx1102.

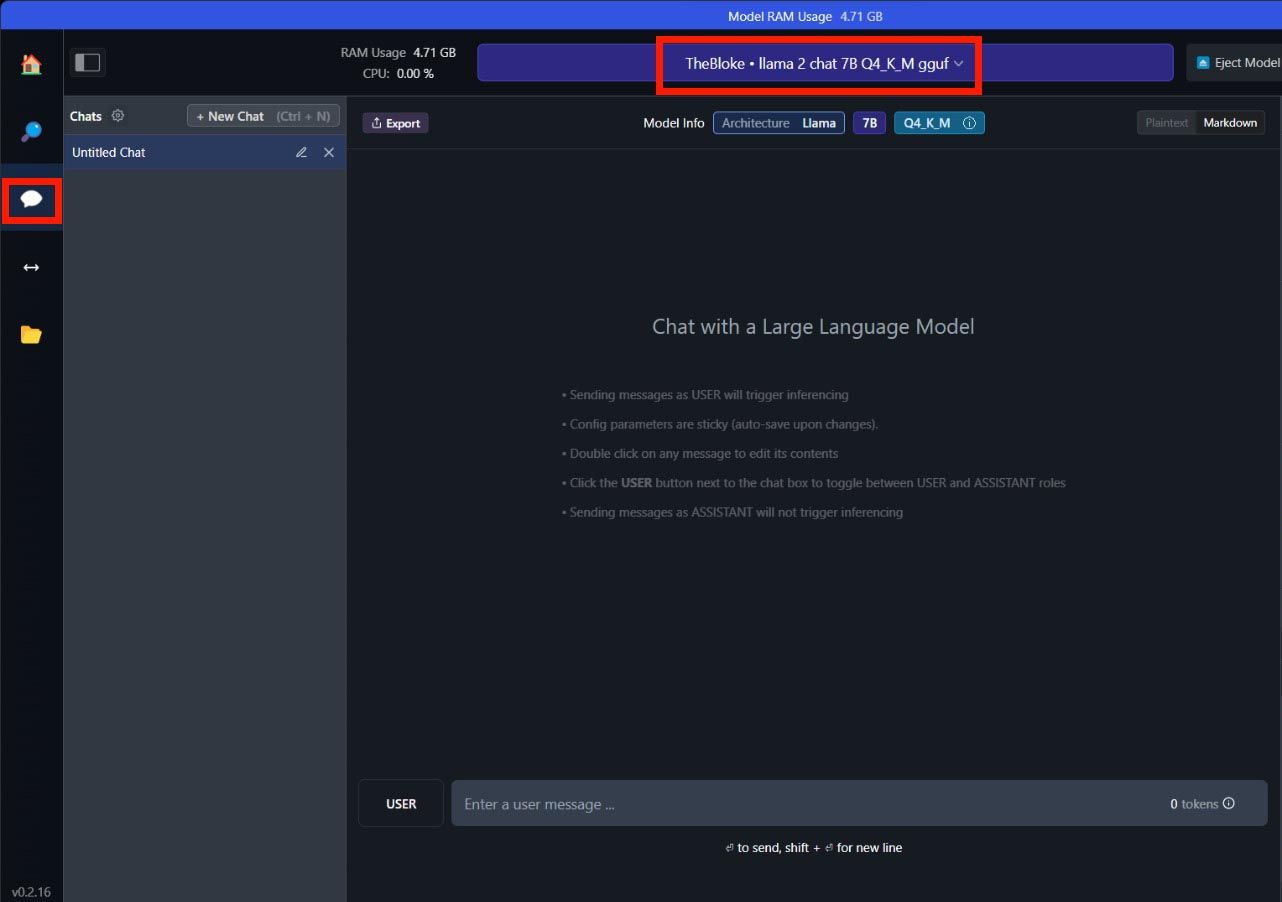

AMD cree que: «Los asistentes de IA se están convirtiendo rápidamente en recursos esenciales para ayudar a aumentar la productividad, la eficiencia o incluso la lluvia de ideas». Su blog también pone el foco en la funcionalidad offline de LM Studio: «El chatbot de IA local en tu máquina no solo no requiere conexión a Internet, sino que tus conversaciones permanecen en tu máquina local». La guía de seis pasos invita a los curiosos a experimentar con un puñado de grandes modelos lingüísticos, sobre todo Mistral 7b y LLAMA v2 7b. Recomiendan encarecidamente seleccionar opciones con «Q4 K M» (cuantificación de 4 bits).